理想汽車自動駕駛團隊5篇論文被世界頂級學術會議錄用!包含世界模型、端到端規劃模型等方面。

車東西6月30日消息,近日,理想汽車宣布其自動駕駛團隊有5篇論文中稿ICCV 2025。

▲理想汽車自動駕駛研發副總裁郎咸朋宣布中稿

計算機視覺國際大會(ICCV,International Conference on Computer Vision)是計算機領域世界頂級的學術會議之一,每兩年舉辦一屆,和CVPR、ECCV并稱計算機視覺三大頂級會議。

而2025年ICCV大會共收到了11239份有效投稿,為歷史最多,這些投稿經過評審后接受2698篇論文,接受率為24%,由此可以看出理想汽車此次多篇論文中稿ICCV的含金量。

理想汽車CEO李想也在社交媒體上發文表示:“如果大家對ICCV論文含金量不太理解,可以類比醫學界的《柳葉刀》論文,每一篇都能代表世界級的‘學術金牌’。”

▲理想汽車CEO李想在社交媒體上發文

此外,李想還提到,除理想汽車自動駕駛團隊中稿的5篇論文外,理想汽車基座模型團隊還有3篇論文中稿,一共8篇論文被ICCV 2025錄用。

一、Hierarchy UGP:用于大規模動態場景重建的層次化統一高斯基元

目前,理想汽車自動駕駛團隊中稿的5篇論文中,名為《Hierarchy UGP》的論文已經公開,這篇論文的是理想汽車與浙江大學合作在世界模型方面的進展。

▲《Hierarchy UGP》

在署名作者中可以看到,理想汽車智能駕駛高級算法專家詹錕、理想汽車高級算法工程師王一達的名字出現了論文署名中。

論文中表示,近年來可微渲染技術的進步顯著提升了動態街景重建的效果。然而,大規模場景和動態元素(如車輛和行人)的復雜性仍是重大挑戰,現有方法通常難以擴展到大型場景或準確建模任意動態。

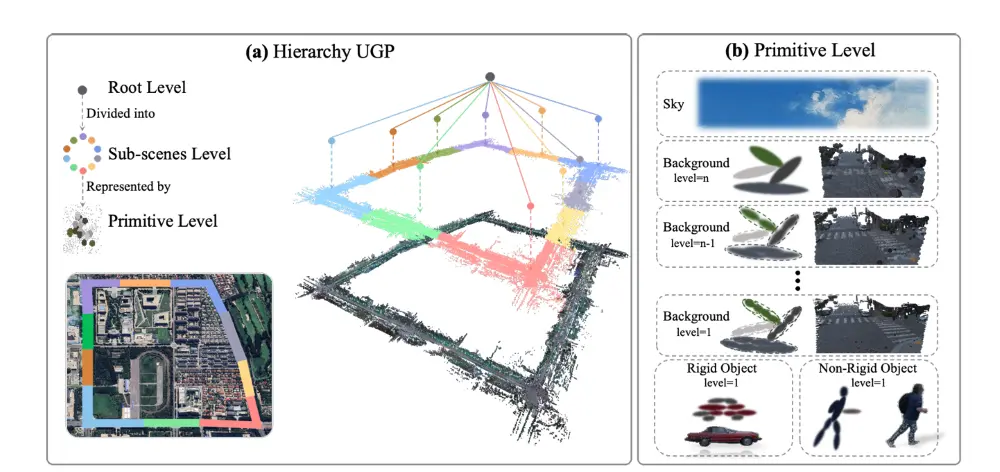

為解決這些限制,研究者提出Hierarchy UGP,其構建了由根層級、子場景層級和基元層級組成的層次結構,并使用在四維空間中定義的統一高斯基元(UGP)作為表示,實現動態靜態長達1km的重建能力。

具體來看,Hierarchy UGP的三層分層結構如下:

1. Root Level(根層):管理整個場景的結構,是渲染和優化的入口。

2. Sub-scenes Level(子場景層):將大規模場景按空間劃分為多個子場景,分別建模天空、背景、剛體和非剛體對象。

3. Primitive Level(基元層):使用定義在四維時空中的統一高斯基元(UGP)對每個元素進行建模。

▲Hierarchy UGP采用三層分層

根層級作為層次結構的入口點。在子場景層級,場景在空間上被劃分為多個子場景,并提取各種元素。在基元層級,每個元素通過UGP建模,其全局位姿由與時間相關的運動先驗控制。

這種層次化設計極大增強了模型的能力,使其能夠建模大規模場景。此外,UGP允許同時重建剛性和非剛性動態。

四維高斯建模UGP在三維空間基礎上引入時間維度,能夠自然表達對象的動態變化,尤其適用于非剛體建模。

層次細節控制(LOD)通過圖像平面投影尺寸選擇渲染基元,提升渲染效率,實現實時渲染。

子場景并行優化采用“塊級對象訓練策略”,避免跨子場景動態對象的干擾,通過“時間尺度初始化”提升大幅運動區域的擬合精度。

虛擬視圖監督在新視角合成任務中引入虛擬視圖監督,有效提升外推質量。

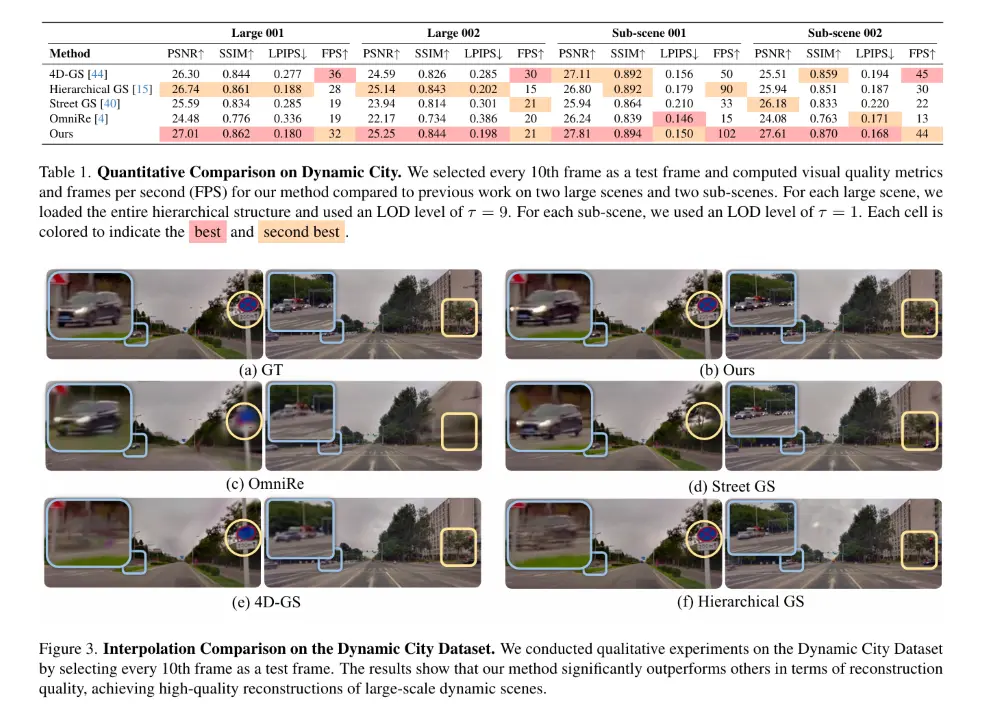

在實驗結果方面,研究者在專有大規模動態街景數據集Dynamic City以及公開的Waymo數據集上進行了實驗。

Dynamic City數據集是包含以10 Hz頻率捕獲的圖像和雷達數據序列,覆蓋600米至1公里以上的街景。

與Waymo和PandaSet等公開數據集相比,Dynamic City數據集包含更廣泛的街景,研究者將該數據集作為開源資源發布,以推進大規模動態街景重建的研究。

為證明算法的有效性并確保公平比較,研究者進行了兩個實驗:一個使用大規模動態場景,另一個使用從大規模場景中提取的子場景。

下圖中的的表格和圖片結果表明,對于插值任務,Hierarchy UGP在大規模動態場景和較小的子場景中均始終優于現有方法。

▲Hierarchy UGP在插值任務上的表現

此外,通過集成LOD技術和基于gsplat的工程增強,Hierarchy UGP實現了大規模動態場景的實時渲染。

對于外推任務,Hierarchy UGP顯著優于所有其他基線方法。這一改進主要歸因于虛擬扭曲視圖的監督。

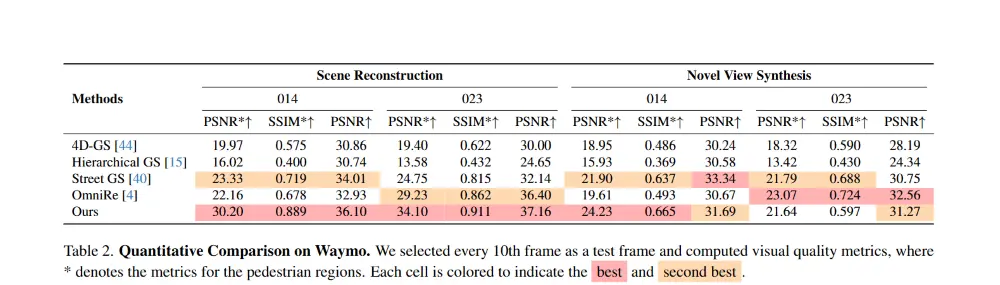

Waymo數據集是一個真實世界數據集,包含在實際道路上收集的數千個駕駛片段,每個片段包含以10Hz采樣的20秒傳感器數據。

下圖中圖片的定性結果表明,Hierarchy UGP在重建方面優于其他方法。

▲Waymo數據集上的定性比較

具體而言,Hierarchy UGP在人體物體上實現了顯著更高的視覺指標,突出了其強大的動態元素建模能力,即使在大運動區域也是如此。

此外,結果表明Hierarchy UGP和OmniRe在測試幀上的視覺質量下降更為明顯。這種下降發生是因為在這些幀中,行人運動完全未知,UGP 和 SMPL 都無法完全捕捉行人的運動,導致性能明顯下降。盡管如此,Hierarchy UGP仍然與最先進的方法具有競爭力。

▲Waymo數據集上的定量比較

最后,研究者們計劃將配套代碼和Dynamic City數據集作為開源資源發布,以推動社區內的進一步研究。

二、共8篇論文中稿 含端到端模型、渲染框架等多方面

另外,除了已經公開的《Hierarchy UGP》論文,在ICCV 2025中理想汽車自動駕駛團隊還有4篇論文中稿。

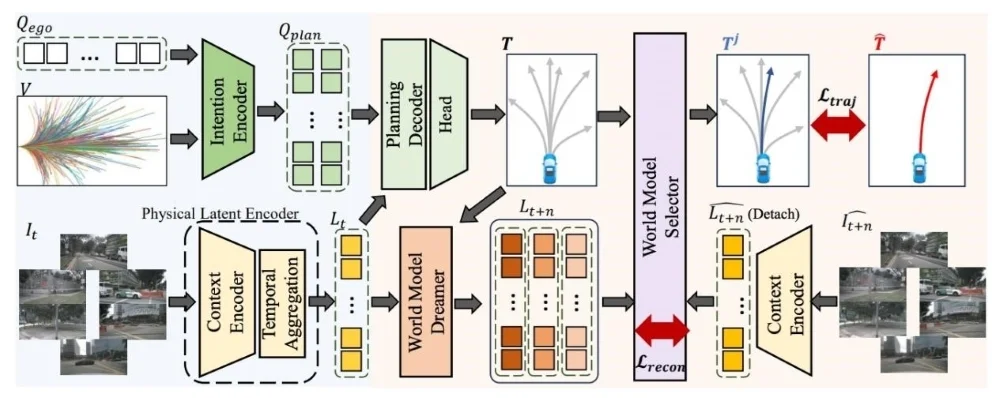

在端到端規劃模型方面,理想汽車與中國科學院合作的《World4Drive》論文,提出業界首個通過自監督學習實現無需感知標注的端到端規劃模型。

▲《World4Drive》

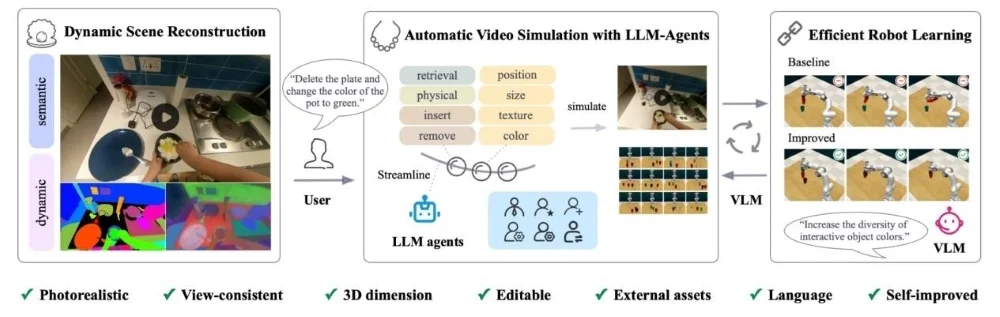

理想汽車與中山大學合作的《RoboPerls》論文,利用3DGS構建面向機器人操作的可編輯視頻仿真框架,能夠從示范視頻構建具有照片級真實感、視角一致的仿真環境,支持機器人的數據合成。

▲《RoboPerls》

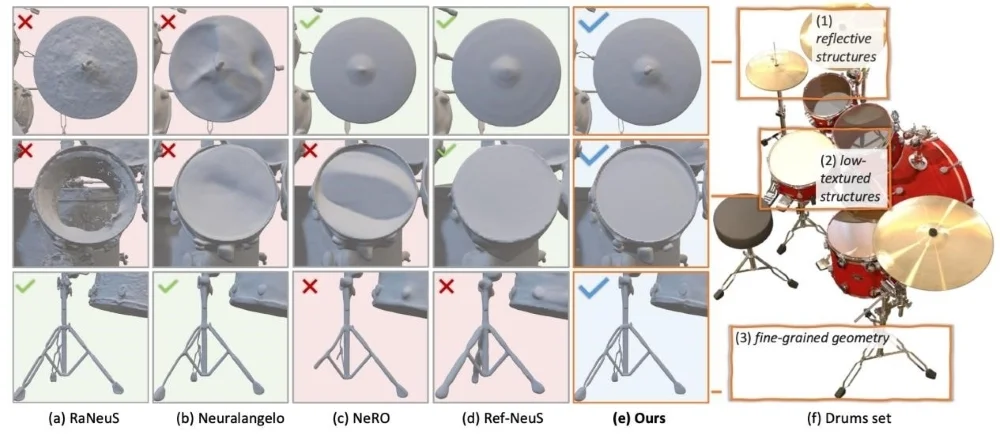

理想汽車獨立完成的《HiNeus》論文,提出了一個統一3D復雜渲染框架,通過三項基礎創新同時解決多視角輻射不一致性、增強低紋理表面恢復并保留精細結構細節。

▲《HiNeus》

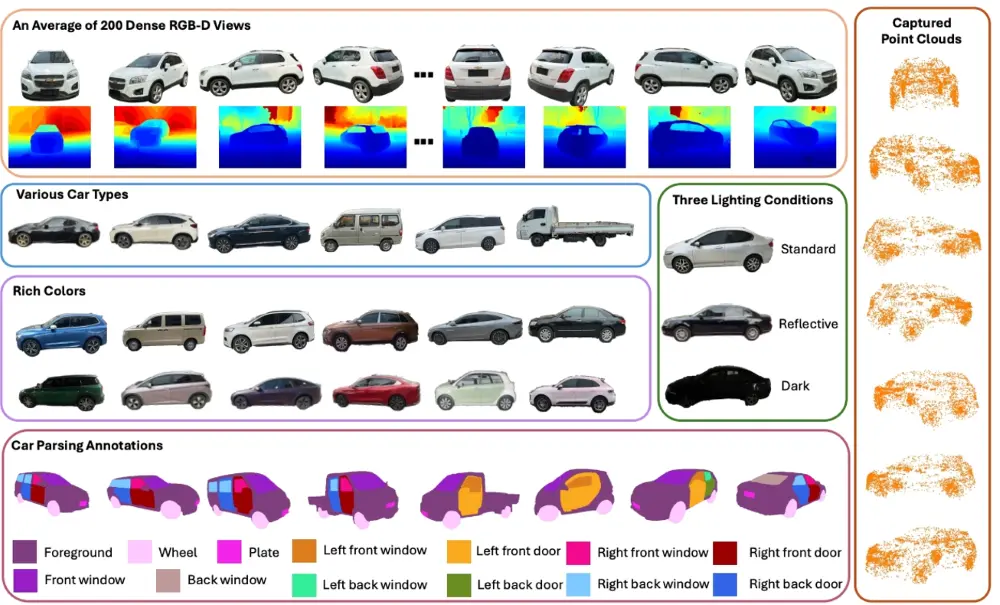

理想汽車與悉尼科技大學合作的《3D RealCar》論文,提出大規模真實三維車輛數據集3D RealCar,具備海量數據、高品質、高多樣性等特性,將有力促進三維車輛識別與重建技術的發展。

▲《3D RealCar》

除理想汽車自動駕駛團隊的論文外,理想汽車基座模型團隊還有三篇論文被ICCV 2025錄用。

理想汽車與中國科學技術大學合作《DH-FaceVid-1K: A Large-Scale High-Quality Dataset for Face Video Generation》,提出大規模高質量人臉視頻數據集DH-FaceVid-1K,具備多種族、高質量、大容量等特性,可用于訓練多模態數字人臉視頻生成基座大模型。

▲《DH-FaceVid-1K: A Large-Scale High-Quality Dataset for Face Video Generation》

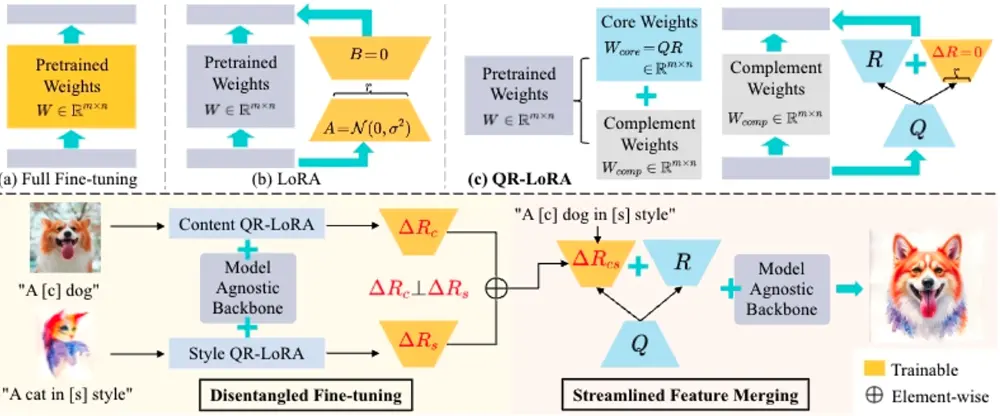

理想汽車與哈爾濱工業大學合作的《QR-LoRA: Efficient and Disentangled Fine-tuning via QR Decomposition for Customized Generation》論文,提出一種全新的圖像定制化微調范式,可適配現有各種生成模型,訓練參數為普通LoRA的一半,微調速度更快,并能用于多屬性組合生成等定制化場景。

▲《QR-LoRA: Efficient and Disentangled Fine-tuning via QR Decomposition for Customized Generation》

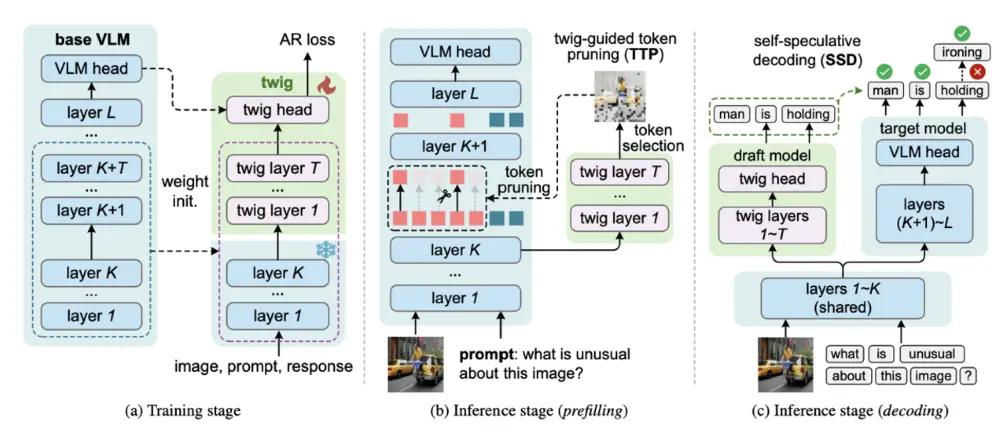

理想汽車發表的《Twig:Growing a Twig to Accelerate Large Vision-Language Models》論文,提出一種自適應VLM Token壓縮&推理加速方法,通過分支引導的Token剪枝策略&自投機解碼策略,自適應地刪除VLM模型LLM推理階段中和Query無關的Token,全方位提升prefill & decode階段的模型計算效率,在長問答Task上可實現1.5倍的提速。

▲《Twig:Growing a Twig to Accelerate Large Vision-Language Models》

結語:理想汽車持續投入基礎理論研究

理想汽車此前已在人工智能領域的頂級學術會議和期刊上嶄露頭角。近3年,理想汽車圍繞端到端、世界模型、VLA和基座模型等核心技術,在AAAI、CVPR、ICRA等頂級學術平臺發表了近50篇論文。

在基礎理論研究過程中,理想汽車在獨立研究之外,還積極與高校展開合作,能夠充分利用高校的科研資源和人才優勢,加速技術研究進程。

而理想汽車能在輔助駕駛、智能座艙等多方面表現出色,離不開其在底層研發的長期投入。